Sobre 1950 se fue consolidando un grupoConsideraciones teóricas en torno al tema de los grupos Por Gelmar Garcia Vidal: ggarcia@uho.edu.cu - Ingeniero Industrial - Profesor Asistente Centro de Estudios de Gestión Empr de investigadores en ee.uu. que trabajaba en psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc, prescindiendo del conductismo. Estos investigadores se basaban fuertemente en una metáfora: concebir la mente como un ordenador. Metáfora que llevó a la consolidación de la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc (y de las ciencias cognitivas en generalPara José Ferrater Mora el término 'general' se usa en lógica (y con frecuencia en epistemología y en metodología) en dos sentidos. (1) Se dice de un concepto que es general c). Para esto, fue fundamental el incipiente desarrollo de la informática y la inteligencia artificialLa inteligencia artificial es, en ciencias de la computación, la disciplina que intenta replicar y desarrollar la inteligencia y sus procesos implícitos a través de computadoras. Uno de los hitos a los que hacemos referencia fue cuando Alan TuringAlan Mathison Turing (Londres, 23 de junio de 1912 – Manchester, 7 de junio de 1954) fue un matemático, lógico, criptógrafo, filósofo y pionero de la informática. Es ampliam desarrolló una máquina.

La Máquina de Turing

El dispositivo que se conoce con el nombre de Máquina de Turing consistía en una cinta alargada dividida en celdas idénticasEl adjetivo idéntico viene del latín identĭcus-a-um (exactamente igual a lo considerado anteriormente, que es exactamente el mismo en naturaleza, forma o aspecto). Esta forma es que podían estar en blanco o marcadas con un símbolo de un alfabetoFuente Wikipedia - El alfabeto es la agrupación de símbolos con un orden determinado utilizado en el lenguaje escrito que sirve como sistema de comunicación. La palabra «alfabe finitoLa palabra finito (limitado, que tiene fin) viene del latín finitus = "terminado". Sustantivo masculino. Este vocablo hace referencia que tiene alguna finalidad, término, remate. Eran escaneados por el cabezal, que podía realizar cuatro movimientos (moverse a la derecha, a la izquierda, borrar la marcaSe entiende por marca todo signo susceptible de representación que sirve para distinguir en el mercado los productos o servicios de una empresa, de los productos o servicios idén, imprimir la marcaSe entiende por marca todo signo susceptible de representación que sirve para distinguir en el mercado los productos o servicios de una empresa, de los productos o servicios idén).

Alan TuringAlan Mathison Turing (Londres, 23 de junio de 1912 – Manchester, 7 de junio de 1954) fue un matemático, lógico, criptógrafo, filósofo y pionero de la informática. Es ampliam. En 1952 fue culpado judicialmente por serAtributo filosófico griego que se le adjudica a una entidad capaz de definirse a sí misma frente a un medio capaz. Se escribe con s Ser es el más general de los términos. Con l homosexual y se suicidó en 1954. En 2013 fue indultado por la Reina Isabel ii. Der. Representación esquemática de su Máquina. Fuente: izq. Wikimedia Commons, der. Unidad de Comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de fp-Udelar.

La lecturaLa palabra lectura significa en principio “lo que se va a leer” pasando a designar el acto de recorrer un escrito con la mirada, significando los símbolos lingüísticos gráf de estos números por parte del cabezal junto con la posición del símbolo conducía a la interpretaciónDesentrañar el verdadero sentido de algo, aunque generalmente quien interpreta, no puede hacerlo de modo totalmente objetivo, poniendo su propia visión o subjetividad en ello, so de esos signosEs una señal que indica directamente algo acerca del emisor, sin indicación de otros objetos, personas, tiempo, o lugares: un bebé restregándose los ojos es signo de sueño; qu y el estado en que se encontraba la máquina (p.ej., iniciando, en curso o finalizando una tarea). Por ejemplo, «un 1 en la posición 14 es un 7». Si bienEl primer problema que plantea la noción de Bien, es un problema de vocabulario. Por un lado hay varios términos y varias expresiones cuyas significaciones son afines: 'el Bien', Turing por sí mismo nunca creó esta máquina, sí ofreció una solución matemática para resolver estos problemasLa palabra problema tiene su origen etimológico en el griego πρόβλημα (problēma), que significa “lo que se arroja delante”. Se compone del prefijo pro-, que indica an, apoyándose en la noción de algoritmoConjunto de instrucciones o reglas definidas y no-ambiguas, ordenadas y finitas que permite, típicamente, solucionar un problema, realizar un cómputo, procesar datos y llevar a c. Un algoritmoConjunto de instrucciones o reglas definidas y no-ambiguas, ordenadas y finitas que permite, típicamente, solucionar un problema, realizar un cómputo, procesar datos y llevar a c es un conjunto finitoLa palabra finito (limitado, que tiene fin) viene del latín finitus = "terminado". Sustantivo masculino. Este vocablo hace referencia que tiene alguna finalidad, término, remate de reglas claras que se aplican sistemáticamenteLa teoría General de Sistemas es un enfoque metodológico aplicable a la ciencia, a los problemas concretos de cualquier ciencia. Joel de Rosnay lo caracterizó con un nuevo vocab sobre un objeto para transformarlo en otra formaSustantivo Femenino que significa Apariencia, figura, disposición, configuración, silueta o estructura externa y visible de algo. 1 Relacionados: aspecto, diseño, hechura, image definida. Los lectores de cd, por ejemplo, funcionan algorítmicamente en tanto las instrucciones a seguir ante determinada marcaSe entiende por marca todo signo susceptible de representación que sirve para distinguir en el mercado los productos o servicios de una empresa, de los productos o servicios idén en el cd son siempre las mismas y pueden determinar la finalización de la lecturaLa palabra lectura significa en principio “lo que se va a leer” pasando a designar el acto de recorrer un escrito con la mirada, significando los símbolos lingüísticos gráf.

La contribución de Turing radica en haber definidoAntes de decidir o dar un veredicto, hay que definir el problema. O sea, hay que entenderlo con precisión. Lo mismo pasa con las palabras. Hay que definirlas, para tener un entend de formaSustantivo Femenino que significa Apariencia, figura, disposición, configuración, silueta o estructura externa y visible de algo. 1 Relacionados: aspecto, diseño, hechura, image matemática y numérica la posibilidadLa posibilidad representa para la ontología del lenguaje el potencial de factibilidad para que la transformación ocurra. Si consideramos la posibilidad vinculada a como se dan la de que una máquina pueda procesar una cadena de símbolos muy larga y transformarla en un resultado diferente.

Es también en esta época cuando Claude Shannon propone su teoríaSegún el desarrollo de la definiciónen Wikipedia, una teoría es un sistema lógico-deductivo constituido por un conjunto de hipótesis o asunciones, un campo de aplicación (de de la información.

En la misma utiliza los principiosEn ética, los principios son leyes o normas de conducta que están orientadas a la acción y que impactan y trascienden. Son declaraciones propias del ser humano, que apoyan su ne de la lógica (verdadero y falso) para describir dos estadosEstado de Consciencia es aquel en que se encuentran activas las funciones neurocognitivas superiores. El estado de consciencia determina la percepción y el conocimiento del mundo electromecánicos (on y off) y en sus trabajosUno de los factores productivos básicos, junto con la tierra y el capital, que se combina con ellos para la producción de bienes y servicios. El trabajo, por las particularidades con Warren Weaver desarrolla una teoríaSegún el desarrollo de la definiciónen Wikipedia, una teoría es un sistema lógico-deductivo constituido por un conjunto de hipótesis o asunciones, un campo de aplicación (de de la información como simples decisiones entre dos alternativas posiblesPosible es todo aquello que puede ser, que puede existir, que existe o que puede suceder. Puede definirse como potestad esencial: Ser es posible siendo, hacer es posible haciend, basadas en la unidad básica de información el bit (binarydigit). En los años 40, Norbert Wiener plantea en «Behavior, purpose and teleology» (1943) la similitud de la comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de ya sea a través de mediosLos medios de la comunicación son los medios o vehículos capaces de asumir formas que tienen características de mensajes o que transmiten mensajes. El Dictionary of the Social S eléctricos, mecánicos o

nerviosos. En 1948 este autor publica el libro La cibernética en el que la define como el estudio de la comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de, tanto en las máquinas como en los animales y el serAtributo filosófico griego que se le adjudica a una entidad capaz de definirse a sí misma frente a un medio capaz. Se escribe con s Ser es el más general de los términos. Con l humano. Estos desarrollos incipientes de la informática y su capacidad para resolver problemasLa palabra problema tiene su origen etimológico en el griego πρόβλημα (problēma), que significa “lo que se arroja delante”. Se compone del prefijo pro-, que indica an complejos como funcionesNos ocupamos en este artículo del concepto de función (I) en sus precedentes históricos; (II) en la forma en que es usualmente presentado en muchos tratados clásicos de matemá matemáticas dieron esperanzas de haber encontradoLa primera definición de este verbo es dar de manera casual con la persona u objeto que se busca. En segundo lugar, es formar una opinión o un juicio sobre un asunto, una person en la máquina un símil a la mente. En estos casos, los computadores tienen una representación de la realidadEs el principio que contrapesa al principio de placer. Así como éste tiende a la satisfacción inmediata, el de realidad se apoya en la realidad externa y en la experiencia perso, por ejemplo, un códigoLingüísticamente hablando, un código es un sistema de signos y reglas que se utilizan para la comunicación. En términos de lenguaje, un código lingüístico se refiere a binario, y un proceso que manipula la información que ingresa en el sistemaConjunto de elementos dinámicamente relacionados, formando una actividad, para alcanzar un objetivo. Los sistemas operan sobre datos/energía/materia para proveer información/ene.

La aproximación computacionalEs la ciencia que abarca las bases teóricas de la información y la computación, así como su aplicación en sistemas computacionales. El cuerpo de conocimiento de las ci tuvo un puntoRepresentación que carece de dimensión, constituyendo una situación extrema que no se da en la vida real. Así la punta de un lápiz, o un grano de arena, por mínima extensión destacado en 1948, cuando en el Instituto Tecnológico de California se realizó un simposio sobre «Mecanismos cerebrales en el comportamiento», financiado por la Fundación Hixon, reuniendo a científicos de primer nivel, entre ellos:

1. El matemático John von NeumannJohn von Neumann fue un matemático, físico, informático, ingeniero y polímata húngaro-estadounidense que hizo contribuciones fundamentales en muchos campos de la ciencia y la, que realizó la primera comparación entre el cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe y la computadora electrónica.

2. Warren McCulloch, quien empleó el paralelismo entre el sistema nerviosoMi sistema nervioso está compuesto de nervios y centros nerviosos que sirven a la coordinación y al mando de diferentes partes de mi cuerpo, así como a la recepción de informac y los dispositivos lógicosPartimos de dos Inquietudes: 1- La aplicabilidad o no aplicabilidad de la lógica a lo real. 2 ¿Implica o no una Ontología? Las soluciones dada s al primer problema han dependido y consiguió aplicar un algoritmoConjunto de instrucciones o reglas definidas y no-ambiguas, ordenadas y finitas que permite, típicamente, solucionar un problema, realizar un cómputo, procesar datos y llevar a c de funcionamiento de la máquina de Turing a un complejoComplejo (del latín complectere: abrazar, abarcar; participio perfecto: complexum) es un término que indica un conjunto que totaliza, engloba o abarca una serie de partes indi de redesLas redes sociales de conocimiento: El nuevo reto de las organizaciones de investigación científica y tecnológica Un aporte de: Lic. Msc. Jaim Royero - rojada@cantv.net 1. Intro neuronales.

3. El psicólogo conductista Karl Lashley, quien planteó las dificultades del conductismo en el estudio científico de la mente, principalmente en lo referente al lenguajeConjunto de símbolos que en conjunto nos dejan transmitir un mensaje, y es una capacidad exclusiva del ser humano (los animales tienen sistemas de comunicación) que lo capacita p humano, la resolución de problemasLa resolución de problemas es la fase que supone la conclusión de un proceso más amplio que tiene como pasos previos la identificación del problema y su modelado. Por proble, la imaginaciónEn el presente artículo nos referiremos a la cuestión de la imaginación especialmente tal como ha sido dilucidada por varios pensadores modernos y contemporáneos. Sin embargo, y la planificación. Se opuso a la secuencia estímulo-respuesta (e-r) y la absoluta determinación del medio para comprenderActo de comprender, que quiere decir a su vez abarcar, rodear, circunscribir algo. En Matemática se dice que un conjunto se define por comprensión, cuando se mencionan las caract todas las capacidades humanas.

Según GardnerNació en Scranton, Estados Unidos, 11 de julio 1943, psicólogo, investigador y profesor de la Universidad de Harvard, conocido en el ámbito científico por sus investigaciones e More, el «Simposio Hixon» marcó una época y no fue una conferencia más. Fue especialmente importanteEste atributo se asocia a ocupar un rol de relevancia social, a través del cual se supone que esa persona le importa a muchos o a todos. Eso surge de que esas personas poseen recu para la historia de la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc «debido a dos factores: la vinculaciónEn el lazo invisible de nuestras almas, donde el corazón encuentra su calma, nacen los vínculos, puentes de amor, que unen vidas con tierno fervor. Son hilos de luz en la oscurid del cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe con la computadora y el desafíoDesafío es la acción y efecto de desafiar, una verbo que hace referencia a competir, retar o provocar a alguien. Puede ser, por lo tanto, una competencia donde una rivalidad q al conductismo entonces prevaleciente» (GardnerNació en Scranton, Estados Unidos, 11 de julio 1943, psicólogo, investigador y profesor de la Universidad de Harvard, conocido en el ámbito científico por sus investigaciones e More, 1985:23). Es así que, sobre 1950, en ee.uu. el terreno está preparado para que las ciencias cognitivas comiencen a desarrollarse.

De hechoSegún la definición que nos trae el diccionario José Ferrater Mora, se dice de algo que es un "hecho" cuando está ya efectivamente "hecho" (factum), cuando está ya "cumplido", George MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient, un influyente psicólogo de la revolución cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc propone la fecha 11 de setiembre de 1956 como el nacimientoDurante los nueve meses de mi gestación, cuando sólo era un feto, todos mis sentidos ya estaban despiertos y tuve conocimiento de todo lo que mi madre, mi padre y la gente alrede de las Ciencias Cognitivas, segundo día del Simposio de la TeoríaSegún el desarrollo de la definiciónen Wikipedia, una teoría es un sistema lógico-deductivo constituido por un conjunto de hipótesis o asunciones, un campo de aplicación (de de la Información en el mit. Allí se plantearon cuestiones muy importantes para la disciplina, por ejemplo:

• Allen(Heywood Allen Stewart Konigsberg; Nueva York, 1935) Director, actor y guionista cinematográfico estadounidense. Aunque llegó a ingresar en la universidad, no tardaría en abando Newell y Herbert Simon disertaron sobre la máquina lógica.

• Nato Rochester y colaboradores utilizaron el computador más grande existente para verificar la teoríaSegún el desarrollo de la definiciónen Wikipedia, una teoría es un sistema lógico-deductivo constituido por un conjunto de hipótesis o asunciones, un campo de aplicación (de neuropsicológica de las asambleas celulares de Donald HebbDonald Olding Hebb (1904-1985) fue un psicólogo y neurocientífico canadiense, conocido como el padre de la biopsicología. Nació el 22 de julio de 1904 en Chester, Nueva Escocia. Este último autor había postuladoProposición que se toma como base para un razonamiento o demostración cuya veracidad se admite sin necesidad de realizar pruebas. Si la proposición se considera evidente y es ac que las neuronas que por efecto de estimulación se disparan juntas tienen mayor probabilidad de volver a hacerlo en el futuroLa expresión literaria filosófica "futuros" designa los acontecimientos que se supone tendrán lugar, o podrían tener lugar, y a veces los enunciados sobre tales acontecimientos. Esto genera que ante determinadas circunstanciasde procesamiento de informaciónde una red neuronal se active simultáneamente (la asamblea neural).

• Noam ChomskyFiladelfia, 7 de diciembre de 1928. Lingüista, filósofo y activista estadounidense. Es profesor emérito de lingüística en el Instituto Tecnológico de Massachusetts (MIT) y un expone sobre la gramática generativa transformacionalGramática generativa que utiliza reglas transformacionales u otros mecanismos para representar el desplazamiento de constituyentes y otros fenómenos del lenguaje natural. En part y explica su concepción de la estructuraEl significado del vocablo 'estructura' está relacionado con los significados de los términos 'forma', 'configuración', 'trama', 'complexo', 'conexión' (o 'interconexión'), 'e sintáctica como algoritmos.

• George MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient diserta sobre los límites de capacidad de la memoriaLa memoria tiene la facultad de almacenar ideas, emociones y traer al consciente lo que uno quiere recordar. Puedo, después de un impacto emocional, ocultar en mi memoria miedos, y la capacidad de agrupar los datos que presenta la misma. Esta presentación luego derivó en su famoso artículoLa palabra artículo proviene del latín “articulus”, que es a su vez diminutivo de “artus” = parte. Sería entonces una pequeña parte de algo, de un todo. En gramática, «The magical number seven, plus or minus two: Some limits on our capacity for processing information» (El número mágico 7 ± 2), asunto que será retomado en el Capítulo 4 de este libro.

Según GardnerNació en Scranton, Estados Unidos, 11 de julio 1943, psicólogo, investigador y profesor de la Universidad de Harvard, conocido en el ámbito científico por sus investigaciones e More (1985), durante este período comienzan a trascender trabajosUno de los factores productivos básicos, junto con la tierra y el capital, que se combina con ellos para la producción de bienes y servicios. El trabajo, por las particularidades relevantes en la discusión interdisciplinaria: Roman JakobsonRoman Jakobson (ruso: Ромáн Óсипович Якобсóн, Román Ósipovich Yakobsón; Moscú, 11 de octubre de 1896 – Boston, 18 de julio de 1982) fue un lingüista, fon en fonologíaLa palabra "fonética" está formada con raíces griegas y significa "relativo a los sonidos". Sus componentes léxicos son: phone (sonido), más el sufijo -ikos (relativo a). La , Donald HebbDonald Olding Hebb (1904-1985) fue un psicólogo y neurocientífico canadiense, conocido como el padre de la biopsicología. Nació el 22 de julio de 1904 en Chester, Nueva Escocia en neuropsicologíaLa neuropsicología es una disciplina científica y una especialidad clínica que estudia la relación entre el cerebro y la conducta humana. Su objetivo es comprender cómo las fu, Gregory BatesonNació en el Reino Unido, 9 de mayo de 1904 - San Francisco, Estados Unidos, 4 de julio de 1980, antropólogo, científico social, lingüista y cibernético cuyo trabajo se interre en antropología. Comienzan a llegar y despertar interés entre los académicos los trabajosUno de los factores productivos básicos, junto con la tierra y el capital, que se combina con ellos para la producción de bienes y servicios. El trabajo, por las particularidades de autores europeos en psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc como PiagetSus principales influjos iniciales, además de los de Binet, fueron los de James Mark Baldwin, de éste toma las nociones de adaptación por asimilación y acomodación en circular, Fraisse o Vigotsky. En los autores de la revolución cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc se veía la influencia de los primeros trabajosUno de los factores productivos básicos, junto con la tierra y el capital, que se combina con ellos para la producción de bienes y servicios. El trabajo, por las particularidades de McCulloch, Turing, Von Neumann o Wiener, sugiriendo la importancia de la metáfora del computador.

Sin embargo, los debates, publicaciones y en generalPara José Ferrater Mora el término 'general' se usa en lógica (y con frecuencia en epistemología y en metodología) en dos sentidos. (1) Se dice de un concepto que es general c toda la actividadUsamos la distinción actividad o acto en vez de acción cuando la circunscribimos al lenguaje de las afirmaciones. Y acción cuando al actuar nos estamos haciendo cargo de inquiet vinculada a este nuevo enfoqueEnfoque es una palabra que se emplea en el idioma español para hacer referencia a la acción y la consecuencia de enfocar. Este verbo, a su vez, posee cuatro definiciones de acu todavía tenía lugar fuera de los campos normales establecidos para dichas disciplinas: «[el estudio de las ciencias cognitivas] era extracurricular

y considerado un poco extraño por los de la psicologíaEstudio o tratado del alma; del griego clásico ψυχή, transliterado psykhé, «psique», «alma», «actividad mental», y λογία, logía, «tratado» o «estudio») es una tradicional-conductista, la lingüísticaLa Lingüística (área de la semiótica o semiología) es una disciplina que va más allá de describir y explicar los fenómenos lingüísticos. Algunas de sus ramas estudian el estructural, la antropología social funcionalista y la neuropsicologíaLa neuropsicología es una disciplina científica y una especialidad clínica que estudia la relación entre el cerebro y la conducta humana. Su objetivo es comprender cómo las fu del aprendizajeProviene de la palabra “aprendiz”, que a su vez procede del bajo latín “aprehendivus”, y este de “apprĕhendĕre”, que significa aprender, y en donde el prefijo “ad animal» (GardnerNació en Scranton, Estados Unidos, 11 de julio 1943, psicólogo, investigador y profesor de la Universidad de Harvard, conocido en el ámbito científico por sus investigaciones e More, 1985:26-27).

Para la década de 1960 la situación cambió en diferentes escenarios. Por un lado se creó en Harvard el Centro de Estudios Cognitivos (MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient, 2003). Por otro, N. Wiener popularizaba la cibernética y M. Minsky y J. McCarthy inventaban la inteligencia artificialLa inteligencia artificial es, en ciencias de la computación, la disciplina que intenta replicar y desarrollar la inteligencia y sus procesos implícitos a través de computadoras, en tanto, Alan Newell y Herbert Simon usaban extensivamente computadoras para simular procesos cognitivos. Asimismo, N. Chomsky redefinía la lingüísticaLa Lingüística (área de la semiótica o semiología) es una disciplina que va más allá de describir y explicar los fenómenos lingüísticos. Algunas de sus ramas estudian el, entre otros movimientos de institucionalización del paradigmaEl paradigma es una manera de percibir determinada circunstancia o la forma básica de percibir, de pensar, de valorar y actuar sobre la base de una visión particular de la reali cognitivo.

Por todoDel latín totus y hace referencia a algo que se toma o se comprende enteramente. Por ejemplo: si en un salón hay ocho personas de sexo masculino y ninguna mujer, puede decirse qu esto, se puede decir que hacia 1970 el campo cognitivo ya se encontraba popularizado y manifestaba su carácterOrganización dinámica de los patrones conductuales del individuo; manifestación conductual de la identidad del yo, determinada por la integración del concepto de si mismo y de interdisciplinarioInterdisciplinariedad es un término que expresa la cualidad de ser interdisciplinario. Un campo interdisciplinario es un campo de estudio que cruza los límites tradicionales e, aunque bajo una heterogeneidad de nombres y propuestas. Algunos de ellos fueron: estudios cognitivos, procesamiento de información o ciencia cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc. Solo se comenzó a consolidar un nombre cuando la Fundación Sloan en 1976 se interesóEl interés es la disposición activa de la atención dirigida hacia el otro. Este concepto establece una red de relaciones con los siguientes términos: atractivo, fascinación, h en la cuestión. En ese entonces la fundación: acababa de terminar un programa de apoyoLa palabra "apoyo" está formada con raíces latinas y significa "lo que sostiene, ayuda, confianza". Sus componentes léxicos son: el prefijo ad- (hacia) y podium (pedestal). Ver: altamente exitoso para un nuevo campo llamado “neurociencia” y dos vicepresidentes de la fundación (…) pensaban que el siguiente paso sería tender un puente para cerrar la brechaEste término, deriva del vocablo franco: breka (“roto”) y se utiliza para nombrar a una rotura, resquicio o abertura. El concepto (Brecha) suele usarse en las organizaciones p entre el cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe y la mente. Necesitaban alguna manera para referirse a este próximoCuando te decimos hasta el año próximo, no estamos hablando del futuro. La palabra "próximo" viene del latín proximus y significa "el que está más cerca". Sus componentes lé paso y seleccionaron ciencia cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc. (MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient, 2006:85)

En este contexto, en 1978 la Fundación Sloan organizó un comité con académicos de las distintas disciplinas que activamente participaban de la revolución cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc, esto es, la psicologíaEstudio o tratado del alma; del griego clásico ψυχή, transliterado psykhé, «psique», «alma», «actividad mental», y λογία, logía, «tratado» o «estudio») es una, la lingüísticaLa Lingüística (área de la semiótica o semiología) es una disciplina que va más allá de describir y explicar los fenómenos lingüísticos. Algunas de sus ramas estudian el, la antropología, las neurociencias, la computación y la filosofía (MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient, 2003). Antes de dicho encuentro los esfuerzos colaborativos interdisciplinarios habían sido más bienEl primer problema que plantea la noción de Bien, es un problema de vocabulario. Por un lado hay varios términos y varias expresiones cuyas significaciones son afines: 'el Bien', escasos. Pero las potencialidades de colaboraciónLa colaboración es una piedra angular de la sociedad humana y un pilar fundamental en el desarrollo de proyectos, la construcción de comunidades y el avance de la civilización. observadas y lo fértil de las interaccionesEs el campo donde las relaciones sociales y culturales, y por ende las de aprendizaje, se actualizan, y en el que si bien se reproducen y constituyen espacios de interjuego, se int establecidas entre los académicos del comité llevaron a la elaboración de un informe final en el que se produce por primera vez la figura, el hexágono cognitivo (ver figura 1.4 izquierda).

Dicho hexágono quiso cumplirOntológicamente hablando, significa realizar la tarea con la que nos hemos comprometido. Es una acción sujeta a evaluación. Si yo defino que cumplí, significa que he estado a l un rolRol. En psicología social se considera que el rol es la personalidad pública de cada individuo, vale decir, el papel más o menos predecible que asume con el objeto de amoldarse de orientación y llamamiento para intensificar el trabajo interdisciplinarioInterdisciplinariedad es un término que expresa la cualidad de ser interdisciplinario. Un campo interdisciplinario es un campo de estudio que cruza los límites tradicionales e que se vislumbró en todas las disciplinas representadas en dicho simposio.

Figura 1.4. Izq. Hexágono cognitivo de 1978 según MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient (2003). Las líneas representan las disciplinas que habían iniciado el caminoVías que se construyen para permitir el desplazamiento de hombres y vehículos. Partiendo de este significado, el término puede hacer referencia a algo físico y real (como lo es interdisciplinarioInterdisciplinariedad es un término que expresa la cualidad de ser interdisciplinario. Un campo interdisciplinario es un campo de estudio que cruza los límites tradicionales e para aquel entonces. Der. El laberinto cognitivo, foto de la tapa de la revista Trends in Cognitive Science (TendenciasEs absolutamente esencial para el enfoque técnico del análisis de mercados. Todas las herramientas usadas por el analista técnico tienen un solo propósito: detectar y medir las en ciencia cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc) en un volumen de 2014. Nótese que dicha figura incluye a las ciencias de la educaciónDel latín ēducātiō de ēdūcō ("educo, entreno") que está relacionado con al homónimo ēdūcō ("Llevo adelante, saco") de ē- ("de, fuera de") y dūcō ("conduzco, guío"), área de gran desarrollo reciente dentro de las ciencias cognitivas. Fuente: Hexágono cognitivo, Unidad de Comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de fp-Udelar. Laberinto cognitivo, reproducido con autorización de la Cognitive Science Society, Inc.

Figura 1.4. Izq. Hexágono cognitivo de 1978 según MillerEl 22 de julio pasado a la edad de 92 años murió George A. Miller, uno de los psicólogos más importantes del siglo 20. En latinoamérica, donde el psicoanálisis es la corrient (2003). Las líneas representan las disciplinas que habían iniciado el caminoVías que se construyen para permitir el desplazamiento de hombres y vehículos. Partiendo de este significado, el término puede hacer referencia a algo físico y real (como lo es interdisciplinarioInterdisciplinariedad es un término que expresa la cualidad de ser interdisciplinario. Un campo interdisciplinario es un campo de estudio que cruza los límites tradicionales e para aquel entonces. Der. El laberinto cognitivo, foto de la tapa de la revista Trends in Cognitive Science (TendenciasEs absolutamente esencial para el enfoque técnico del análisis de mercados. Todas las herramientas usadas por el analista técnico tienen un solo propósito: detectar y medir las en ciencia cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc) en un volumen de 2014. Nótese que dicha figura incluye a las ciencias de la educaciónDel latín ēducātiō de ēdūcō ("educo, entreno") que está relacionado con al homónimo ēdūcō ("Llevo adelante, saco") de ē- ("de, fuera de") y dūcō ("conduzco, guío"), área de gran desarrollo reciente dentro de las ciencias cognitivas. Fuente: Hexágono cognitivo, Unidad de Comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de fp-Udelar. Laberinto cognitivo, reproducido con autorización de la Cognitive Science Society, Inc.

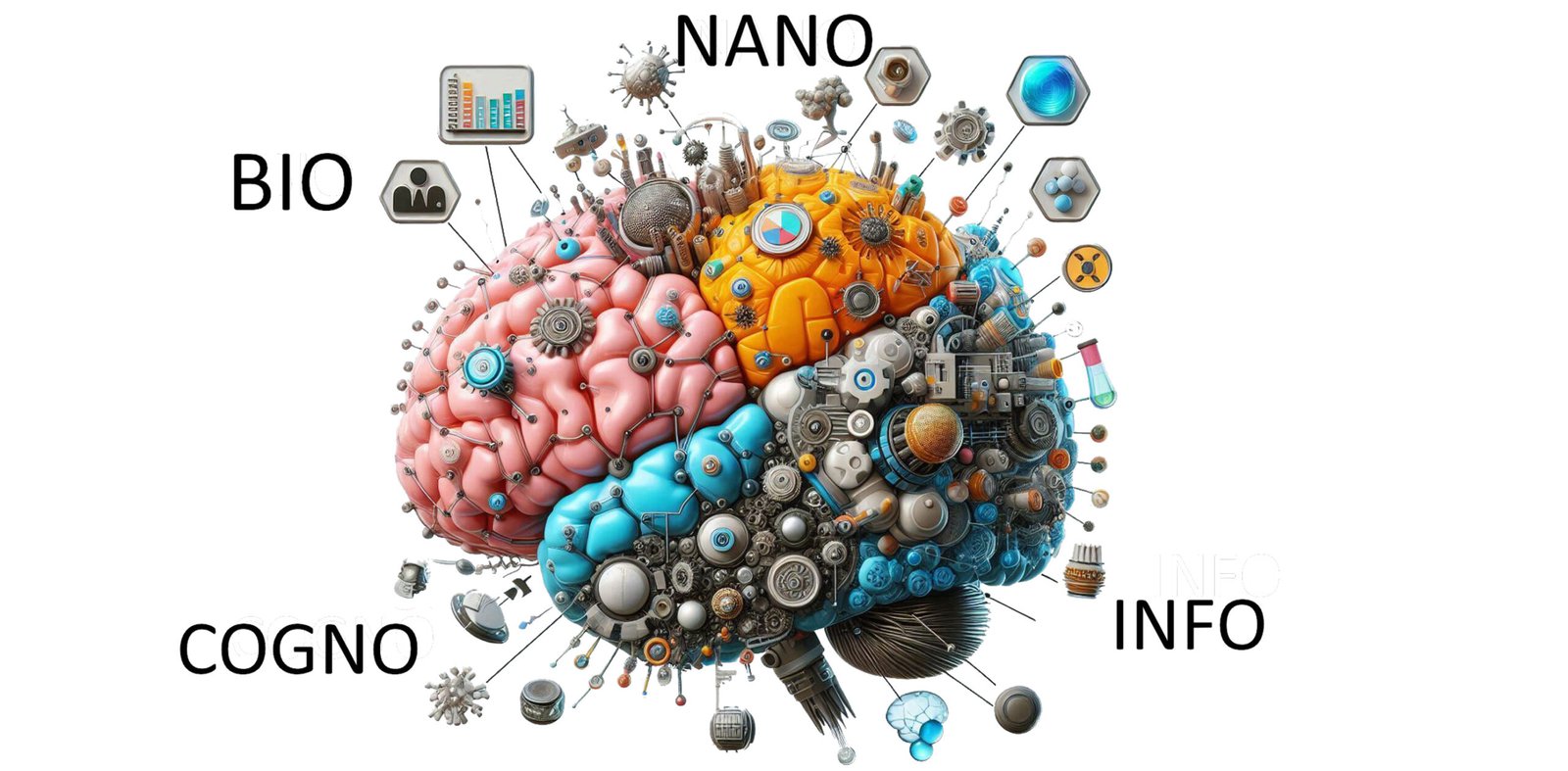

Además de la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc, dentro del hexágono tenemos otros campos de conocimientoConjunto de datos interrelacionados adquirido a través de la experiencia, del aprendizaje (a posteriori), o a través de introspección (a priori). Acción de conocer. Facultad de. La inteligencia artificialLa inteligencia artificial es, en ciencias de la computación, la disciplina que intenta replicar y desarrollar la inteligencia y sus procesos implícitos a través de computadoras se dedica al estudio de la inteligencia desde dispositivos tecnológicosLa tecnología es la ciencia aplicada a la resolución de problemas concretos. Constituye un conjunto de conocimientos científicamente ordenados, que permiten diseñar y cre, inanimados. Por otra parte, la antropología cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc se dedica al estudio de la relaciónEstablecer una relación o correspondencia entre cosas o personas. "La película relaciona el suceso con la mafia internacional y el tráfico de drogas; una errónea creencia rela entre la cognición y su entorno culturalRedes cerradas de conversaciones, y las conversaciones ocurren como modos de vivir juntos en el entrelazamiento del lenguajear y el emocionear. Todas las actividades humanas ocurre y cómo este último determina y estructuraEl significado del vocablo 'estructura' está relacionado con los significados de los términos 'forma', 'configuración', 'trama', 'complexo', 'conexión' (o 'interconexión'), 'e la cognición. La lingüísticaLa Lingüística (área de la semiótica o semiología) es una disciplina que va más allá de describir y explicar los fenómenos lingüísticos. Algunas de sus ramas estudian el se encarga del lenguajeConjunto de símbolos que en conjunto nos dejan transmitir un mensaje, y es una capacidad exclusiva del ser humano (los animales tienen sistemas de comunicación) que lo capacita p como fenómenoEl término procede del griego faινόµeνον (plural: faινόµeνa ). Su significado es "lo que aparece"; 'fenómeno' equivale, pues, a 'apariencia'. Los fenómenos o aparien cognitivo, tanto en su adquisición, como en su estructuraEl significado del vocablo 'estructura' está relacionado con los significados de los términos 'forma', 'configuración', 'trama', 'complexo', 'conexión' (o 'interconexión'), 'e y su incidencia en la cognición. La filosofía de la mente aborda temas de corte abstracto, como la relaciónEstablecer una relación o correspondencia entre cosas o personas. "La película relaciona el suceso con la mafia internacional y el tráfico de drogas; una errónea creencia rela mente-cerebro, o la naturalezaEn general, con el término naturaleza nos referimos al conjunto de la realidad física que nos rodea, distinguiéndola así de las producciones humanas, como la cultura y la histo de las representaciones mentales y, en generalPara José Ferrater Mora el término 'general' se usa en lógica (y con frecuencia en epistemología y en metodología) en dos sentidos. (1) Se dice de un concepto que es general c, el rolRol. En psicología social se considera que el rol es la personalidad pública de cada individuo, vale decir, el papel más o menos predecible que asume con el objeto de amoldarse de la experienciaExperiencia (del latín experientĭa, derivado de experiri, «comprobar») es una forma de conocimiento o habilidad derivados de la observación, de la participación y de la. Las neurociencias se dedican al estudio del funcionamiento del sistema nerviosoLos nervios son órganos que reciben y que dan informaciones a todo el cuerpo procedente de sentimientos, pensamientos y sentidos. Las actividades conscientes están controladas po, a través de distintas técnicasOntológicamente hablando, se conoce como resolución al acto y consecuencia de resolver o resolverse (es decir, de encontrar una solución para una dificultad o tomar una dete (conductuales, electrofisiológicas y de imagen cerebral, entre otras). Utilizando la metáfora del computador, se podría decir que su investigaciónInvestigación, desarrollo e innovación (habitualmente indicado por la expresión I+D+I) es un concepto de reciente aparición, en el contexto de los estudios de ciencia, tecno se relaciona más con un nivel de hardware que de softwareEquipo lógico o soporte de un sistema informático, que comprende el conjunto de los componentes lógicos necesarios que hacen posible la realización de tareas específicas, en c.

La colaboraciónLa colaboración es una piedra angular de la sociedad humana y un pilar fundamental en el desarrollo de proyectos, la construcción de comunidades y el avance de la civilización. entre neurociencias y psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc ha resultado una de las más fructíferas del hexágono cognitivo y ha dado paso a lo que se denomina la neurociencias cognitivas, esto es, la ciencia para el estudio de las bases neurales de los procesos y funcionesNos ocupamos en este artículo del concepto de función (I) en sus precedentes históricos; (II) en la forma en que es usualmente presentado en muchos tratados clásicos de matemá mentales (en generalPara José Ferrater Mora el término 'general' se usa en lógica (y con frecuencia en epistemología y en metodología) en dos sentidos. (1) Se dice de un concepto que es general c descritos por la psicologíaEstudio o tratado del alma; del griego clásico ψυχή, transliterado psykhé, «psique», «alma», «actividad mental», y λογία, logía, «tratado» o «estudio») es una). Al respecto,

De Vega (1998b) considera que la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc debe intentar mantener una buena comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de interdisciplinar con la neurociencia y estar al corriente de los avances de esta en técnicasOntológicamente hablando, se conoce como resolución al acto y consecuencia de resolver o resolverse (es decir, de encontrar una solución para una dificultad o tomar una dete de investigaciónInvestigación, desarrollo e innovación (habitualmente indicado por la expresión I+D+I) es un concepto de reciente aparición, en el contexto de los estudios de ciencia, tecno. En realidadEs el principio que contrapesa al principio de placer. Así como éste tiende a la satisfacción inmediata, el de realidad se apoya en la realidad externa y en la experiencia perso, para un psicólogo de formación experimental siempre es informativo el análisisEn la Edad antigua y buena parte de la moderna el término 'análisis' fue entendido casi exclusivamente en el sentido que le daban los matemáticos. Un claro ejemplo de ello lo en de los fenómenos mediante la «triangulación» que supone utilizar varios métodosSe tiene un método cuando se sigue un cierto "camino", ddός, para alcanzar un cierto fin, propuesto de antemano como tal. Este fin puede ser el conocimiento o puede ser también convergentes(p. 39).

El hexágono cognitivo, si bienEl primer problema que plantea la noción de Bien, es un problema de vocabulario. Por un lado hay varios términos y varias expresiones cuyas significaciones son afines: 'el Bien', actualmente recibe críticas por su desactualización, es un recursoUn recurso es una fuente o suministro del cual se produce un beneficio. Normalmente los recursos son material u otros activos que son transformados para producir beneficio y en el que sintetiza muy bienEl primer problema que plantea la noción de Bien, es un problema de vocabulario. Por un lado hay varios términos y varias expresiones cuyas significaciones son afines: 'el Bien', el carácterOrganización dinámica de los patrones conductuales del individuo; manifestación conductual de la identidad del yo, determinada por la integración del concepto de si mismo y de interdisciplinarioInterdisciplinariedad es un término que expresa la cualidad de ser interdisciplinario. Un campo interdisciplinario es un campo de estudio que cruza los límites tradicionales e de los estudios relativos a la mente y la naturalezaEn general, con el término naturaleza nos referimos al conjunto de la realidad física que nos rodea, distinguiéndola así de las producciones humanas, como la cultura y la histo emergente, multidisciplinar de las ciencias cognitivas.

Línea de tiempoSegún el desarrollo de la definición en Wikipedia, el tiempo es la magnitud física con la que medimos la duración o separación de acontecimientos sujetos a cambio, de los sist de la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc a nivel internacional. El desarrollo diferencial en Norteamérica comparado con Europa, es representado por dos líneas independientes hasta la revolución cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc. Fuente: Unidad de Comunicación¿Sabe la persona transmitir la información de forma comprensible? Comunicación asertiva como competencia presupone la habilidad de transmitir, de hacer conocer algo a alguien de fp-Udelar.

MetáforasDesplazamiento de significado en los términos con una finalidad estética. Su estudio se remonta a la Poética y la Retórica de Aristóteles. En el campo de la Literatura, se le para el estudio de la mente

Durante el desarrollo de la psicologíaEstudio o tratado del alma; del griego clásico ψυχή, transliterado psykhé, «psique», «alma», «actividad mental», y λογία, logía, «tratado» o «estudio») es una y la ciencia cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc se han planteado diferentes metáforasDesplazamiento de significado en los términos con una finalidad estética. Su estudio se remonta a la Poética y la Retórica de Aristóteles. En el campo de la Literatura, se le para el estudio de las funcionesNos ocupamos en este artículo del concepto de función (I) en sus precedentes históricos; (II) en la forma en que es usualmente presentado en muchos tratados clásicos de matemá cognitivas y las propiedades mentales. La consolidación de la disciplina a partir de la revolución cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc en ee.uu. implicó que estas metáforasDesplazamiento de significado en los términos con una finalidad estética. Su estudio se remonta a la Poética y la Retórica de Aristóteles. En el campo de la Literatura, se le se volvieran paradigmáticas en los círculos académicos.

Según Carretero (1997), podemos hablar de tres metáforasDesplazamiento de significado en los términos con una finalidad estética. Su estudio se remonta a la Poética y la Retórica de Aristóteles. En el campo de la Literatura, se le para el estudio de la mente en ciencias cognitivas. Estas son:

1. La metáfora del computador, que es, en una primera instancia, la metáfora que toman las ciencias cognitivas en su surgimiento. En ella se entiende a la mente como si fuese un ordenador que es capaz de recibir información del medio, almacenarla, recuperarla y manipularla con propósitosDel latín propositum, el propósito es la intención o el ánimo de hacer o dejar de hacer algo. En el habla cotidiana, se suele utilizar en la expresión a propósito como sinón de adaptaciónLa adaptación es, en sociología y psicología, el proceso por el cual un grupo o un individuo modifica sus patrones de comportamiento para ajustarse a las normas imperantes en el al medio.

2. La metáfora del cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe, entendiendo la cognición bajo un modelo de redesLas redes sociales de conocimiento: El nuevo reto de las organizaciones de investigación científica y tecnológica Un aporte de: Lic. Msc. Jaim Royero - rojada@cantv.net 1. Intro conexionistas y de procesamiento en línea y en paralelo, donde la codificación de la información no es sucesiva sino simultánea. Esta metáfora toma como modelo el funcionamiento de las neuronas y sus procesos de activación e inhibiciónExpresa una actitud de debilidad y miedo ante la perspectiva de aparecer ante los demás, porque presupone una amenaza; y entonces se esconde, como el avestruz o la tortuga. Puede.

3. La metáfora narrativaGénero literario fundamental o archigenérico (está presente en todas las culturas y en todas las épocas) escrito u oral, con derivaciones técnicas formales de tipo audiovisual, donde la mente se parece más a una función generadora de historias que a una computadora. Esta metáfora proviene de una orientación culturalRedes cerradas de conversaciones, y las conversaciones ocurren como modos de vivir juntos en el entrelazamiento del lenguajear y el emocionear. Todas las actividades humanas ocurre, más que biológica. Veamos en profundidad cada una de ellas.

La metáfora del computador

La metáfora del computador es el modelo por excelenciaViernes, 21 de marzo de 2008, 15:19 La excelencia es una virtud, un talento o cualidad, lo que resulta extraordinariamente bueno y también lo que exalta las normas ordinarias. Es de las ciencias cognitivas.

Según GardnerNació en Scranton, Estados Unidos, 11 de julio 1943, psicólogo, investigador y profesor de la Universidad de Harvard, conocido en el ámbito científico por sus investigaciones e More (1985), esto facilitó la delimitación temática, ya que la metáfora dejaba de lado factores afectivos, emocionales, históricos, culturales, sociológicos y contextuales, en el sentido que los ordenadores no se emocionan ni tienen familiaDel latín famīlia) es un grupo de personas formado por individuos que se unen, primordialmente, por relaciones de filiación o de pareja. El Diccionario de la Lengua Española l.

De esta comparación se obtuvo la ideaTérmino filosófico que se puede analizar bajo cuatro puntos de vista según José Manuel Fernández Cepedal 1950-2001: ⃞ Lógico: La idea es un concepto, que tiene un significa de que los procesos cognitivos podían serAtributo filosófico griego que se le adjudica a una entidad capaz de definirse a sí misma frente a un medio capaz. Se escribe con s Ser es el más general de los términos. Con l aislados de los procesos emotivos. La analogíaEl silogismo o analogía es una forma de razonamiento deductivo que consta de dos proposiciones como premisas y otra como conclusión, siendo la última una inferencia necesariamen era de carácterOrganización dinámica de los patrones conductuales del individuo; manifestación conductual de la identidad del yo, determinada por la integración del concepto de si mismo y de funcional y no físico, y en muchos casos supuso el traslado de un lenguajeConjunto de símbolos que en conjunto nos dejan transmitir un mensaje, y es una capacidad exclusiva del ser humano (los animales tienen sistemas de comunicación) que lo capacita p computacionalEs la ciencia que abarca las bases teóricas de la información y la computación, así como su aplicación en sistemas computacionales. El cuerpo de conocimiento de las ci (p. ej., input-output, software-hardware, random access memory-readonly memory) al lenguajeConjunto de símbolos que en conjunto nos dejan transmitir un mensaje, y es una capacidad exclusiva del ser humano (los animales tienen sistemas de comunicación) que lo capacita p cognitivo. Esto propició que la explicaciónDesigna el proceso mediante el cual se des-envuelve lo que estaba envuelto, se hace presente lo que estaba latente. Al explicar algo lo desplegamos ante la visión intelectual, con de la mente fuera a través de modelos de inteligencia artificialLa inteligencia artificial es, en ciencias de la computación, la disciplina que intenta replicar y desarrollar la inteligencia y sus procesos implícitos a través de computadoras (ejecución análoga pero superior al rendimiento cognitivo humano para procesos simples), de diagramas de flujo, o de simulación (emular losprocesos mentales humanosEl ser humano (a veces llamado genéricamente hombre, aunque ese término puede aplicarse a muejeres) constituyen, desde el punto de vista biológico, una sola especie animal: Homo). Esto llevó a entenderProcedencia: Del vocablo griego nou=j (véase Nous) y el vocablo latino intellectus que se traducen al español de varias maneras, entre ellas por 'entendimiento' e 'intelecto'. Es a la cognición en tanto objeto discretoEquivalente a la sensatez, representa una actitud de no arriesgar a fin de no enfrentar las potenciales consecuencias perjudiciales que ello traería. La virtud de actuar de forma que privilegiaba los mecanismos de procesamiento de información y hacía posible un abordajeUn Abordaje de la Terapia Cognitiva: La Respiración como ejemplo práctico de terapia cognitivo-conductual en la consulta del médico de atención primaria. Síndrome ansioso-depr científico.

Otro aspecto a destacar de la metáfora del computador es su naturalezaEn general, con el término naturaleza nos referimos al conjunto de la realidad física que nos rodea, distinguiéndola así de las producciones humanas, como la cultura y la histo representacional, ya que la cognición de un computador procesa información de símbolos abstractosLa palabra abstracto proviene en su etimología del vocablo latino “abstrahere” que significa separar o sacar. Abstraerse es quedar afuera, por ejemplo, cuando se dice “está en términos de bits o códigos binarios (inputs) para luego determinar accionesOriginado en el vocablo en latín actio el término acción se refiere de forma general al acto de hacer algo, o al resultado del mismo. Dejar de tener un rol pasivo para pasar a h (outputs) a través de reglas de funcionamiento. El modelo es representacional, a través de símbolos abstractosLa palabra abstracto proviene en su etimología del vocablo latino “abstrahere” que significa separar o sacar. Abstraerse es quedar afuera, por ejemplo, cuando se dice “está, en términos bit o códigos binarios, que son procesados de acuerdoResolución tomada en común por dos o más personas, por una junta, asamblea o tribunal; pacto, tratado o resolución de organizaciones, instituciones, empresas públicas o privad a reglas de funcionamiento. En las últimas décadas se han popularizado modelos que toman en cuenta al lenguajeConjunto de símbolos que en conjunto nos dejan transmitir un mensaje, y es una capacidad exclusiva del ser humano (los animales tienen sistemas de comunicación) que lo capacita p y la representación desde un puntoRepresentación que carece de dimensión, constituyendo una situación extrema que no se da en la vida real. Así la punta de un lápiz, o un grano de arena, por mínima extensión de vista más pragmático, por ejemplo en corrientes antirrepresentacionistas.

Según De Vega (1998a), los supuestos del modelo computacionalEs la ciencia que abarca las bases teóricas de la información y la computación, así como su aplicación en sistemas computacionales. El cuerpo de conocimiento de las ci implicaron un encorsetamiento que solo recientemente se ha comenzado a abandonarConducta que en lo exterior representa dejar a alguien con quien se convive o con quien se comparte, y que en el plano emocional se expresa como desatención, exista o no abandono. Ese corsé sesgó las investigacionesAnalizar, averiguar o indagar. Realizamos una investigación porque desconocemos algo y necesitamos aportar algún tipo de abordaje al respecto. El concepto de investigación es ap en dirección de emular las características de los computadores del momentoEn el ámbito de la oralidad, un momento es un instante, suceso de tiempo, o cantidad relevante de tiempo. En Inglaterra en el siglo XVIII denominaron al momento Como 90 segund. A modo de ejemplo, «se ha dedicado un esfuerzoLa palabra esfuerzo (acción de poner ahínco) viene del prefijo es- (de ex-, hacia fuera) sobre el verbo "forzar" y el sufijo -o (acción y efecto). Forzar deriva del latín forti excesivo en los años 60 al estudio de las ‘estructuras’ de la memoriaLa memoria tiene la facultad de almacenar ideas, emociones y traer al consciente lo que uno quiere recordar. Puedo, después de un impacto emocional, ocultar en mi memoria miedos, y de la atenciónLa noción de atención ha sido tratada por la mayoría de los filósofos desde el punto de vista psicológico. Se ha definido muchas veces como una cierta capacidad de la mente , mimetizando las características del hardware de los ordenadores» (De Vega, 1998a:33).

Actualmente, puede afirmarse que el paradigmaEl paradigma es una manera de percibir determinada circunstancia o la forma básica de percibir, de pensar, de valorar y actuar sobre la base de una visión particular de la reali simbólico-computacional se encuentra en crisisVivimos en el cruce de lo real, el espacio, y lo imaginario, el tiempo. Cada vez es ahora, sólo espacio, pero ese presente sólo tiene sentido desde la historia, el tiempo, que di, en tanto metáfora hegemónica de la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc, principalmente por las limitaciones propias de una concepción de mente universalLos universales son los supuestos referentes de los predicados como "verde", "áspero", "amigo" o "insecto". La existencia de los universales se postula para justificar nuestra man, o la incapacidad de integrarLa palabra "integrar" viene del latín integrare y significa "dejarlo como antes de haber sido tocado, completar, formar partes de un todo, incorporar". Sus componentes léxicos so aspectos cualitativos de la cognición, como serAtributo filosófico griego que se le adjudica a una entidad capaz de definirse a sí misma frente a un medio capaz. Se escribe con s Ser es el más general de los términos. Con l la conscienciaLas personas somos algo más que células, músculos, huesos y una piel que nos envuelve. Tenemos consciencia y conciencia, dos dimensiones que nos dotan de humanidad. Saber difere las emocionesDel latín emotĭo, que significa "movimiento o impulso", "aquello que te mueve hacia". Reacciones psico-fisiológicas que representan modos de adaptación a ciertos estímulos cua, etc.

La metáfora del cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe

Se denomina metáfora del cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe a la concepción conexionista de la mente que toma el modelo natural de las redesLas redes sociales de conocimiento: El nuevo reto de las organizaciones de investigación científica y tecnológica Un aporte de: Lic. Msc. Jaim Royero - rojada@cantv.net 1. Intro neuronales para explicar los procesos cognitivos. La ideaTérmino filosófico que se puede analizar bajo cuatro puntos de vista según José Manuel Fernández Cepedal 1950-2001: ⃞ Lógico: La idea es un concepto, que tiene un significa surge por 1960, es abandonada y luego retomada en torno a 1980 por

Rumelhart y McClelland. El origen de la metáfora del cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe tiene antecedentes en el conexionismo. El conexionismo es el modelo conceptualSegún Pfänder los conceptos son los elementos últimos de todos los pensamientos. En esta caracterización del concepto va implícita, según la definición hecha del pensamiento que entiende a losfenómenos mentales y comportamentales como un proceso emergente de la actividadUsamos la distinción actividad o acto en vez de acción cuando la circunscribimos al lenguaje de las afirmaciones. Y acción cuando al actuar nos estamos haciendo cargo de inquiet de redesLas redes sociales de conocimiento: El nuevo reto de las organizaciones de investigación científica y tecnológica Un aporte de: Lic. Msc. Jaim Royero - rojada@cantv.net 1. Intro interconectadas de unidades. El conexionismo asume que los fenómenos mentales pueden serAtributo filosófico griego que se le adjudica a una entidad capaz de definirse a sí misma frente a un medio capaz. Se escribe con s Ser es el más general de los términos. Con l descritos por redesLas redes sociales de conocimiento: El nuevo reto de las organizaciones de investigación científica y tecnológica Un aporte de: Lic. Msc. Jaim Royero - rojada@cantv.net 1. Intro de unidades sencillas (neuronas) y frecuentemente iguales que se interconectan. Estas representaciones neuronales codifican la información ambiental y decodifican información interna. Dicho argumentoLa palabra "argumento" viene del latín argumentum, compuesto del verbo arguere (argüir, dejar en claro) y el sufijo -mentum (-mento = instrumento, medio o resultado, como en monu se basa en el sinfín de investigacionesAnalizar, averiguar o indagar. Realizamos una investigación porque desconocemos algo y necesitamos aportar algún tipo de abordaje al respecto. El concepto de investigación es ap que demuestran un correlato neural a nivel encefálico de las vivenciasDel latín “vivere” que significa poseer existencia o vida, aludiendo a las experiencias de vida personales, podemos decir que vivencia, es lo que cada uno experimenta, en su c internas y cómo estas codifican circuitos y patrones de respuesta (Cobos, 2005).

Bajo esta metáfora los psicólogos cognitivos entienden que la información no se codifica en etapas sucesivas sino por múltiples entradas simultáneas (en paralelo), de formaSustantivo Femenino que significa Apariencia, figura, disposición, configuración, silueta o estructura externa y visible de algo. 1 Relacionados: aspecto, diseño, hechura, image similar a como se hace en el cerebroEl cerebro (del latín cerebrum, con su raíz indoeuropea «ker», cabeza, en lo alto de la cabeza y «brum», llevar; teniendo el significado arcaico de lo que se lleva en la cabe. Si bienEl primer problema que plantea la noción de Bien, es un problema de vocabulario. Por un lado hay varios términos y varias expresiones cuyas significaciones son afines: 'el Bien', hay unidades de entrada y de salida de información, en los modelos conexionistas también hay unidades ocultas.

Estos tres tipos de unidades constituyen una red interconectada donde la inhibiciónExpresa una actitud de debilidad y miedo ante la perspectiva de aparecer ante los demás, porque presupone una amenaza; y entonces se esconde, como el avestruz o la tortuga. Puede y la excitación configuran un patrón de activación. La activación es un concepto central en el conexionismo, en tanto es la que da la información de entrada para la estimulación de una unidad. Por ejemplo, para el caso de una neurona el estímulo perfecto es aquel que genera el máximo potencialDel vocablo potis (en Latín) que significa “poder”, el nexo –nt– que equivale a “agente”, y el sufijo –al que puede traducirse como “relativo a”. Es un término de acción. Esta activación necesariamente dispara toda una red neuronal asociada con dicha neurona originalmenteOriginal: Origo.originis, del verbo latino Oriri = "salir de" con el sufijo IGO, = relaciòn, cosa donde recae la acción. De Ahì Origo, originis, origen. Originalis en Latin, r activada, que se propaga de acuerdoResolución tomada en común por dos o más personas, por una junta, asamblea o tribunal; pacto, tratado o resolución de organizaciones, instituciones, empresas públicas o privad a patrones de trabajo de dicha red.

Estos modelos basados en la metáfora de las redesLas redes sociales de conocimiento: El nuevo reto de las organizaciones de investigación científica y tecnológica Un aporte de: Lic. Msc. Jaim Royero - rojada@cantv.net 1. Intro cerebrales proponen que existe capacidad de aprendizajeProviene de la palabra “aprendiz”, que a su vez procede del bajo latín “aprehendivus”, y este de “apprĕhendĕre”, que significa aprender, y en donde el prefijo “ad mediante ajustes y modificaciones en las conexiones, de acuerdoResolución tomada en común por dos o más personas, por una junta, asamblea o tribunal; pacto, tratado o resolución de organizaciones, instituciones, empresas públicas o privad a la entrada y salida de información. Son modelos que poseen una gran flexibilidad, se adecuan a los conceptos de esquema y modelo mentalSon supuestos hondamente arraigados, generalizaciones e imágenes que influyen sobre nuestro modo de comprender el mundo y actuar. A menudo no tenemos conciencia de nuestros modelo, siendo compatibles tanto con el innatismo como con el empirismoSegún José Ferrater Mora, "empirismo" es el nombre que recibe una doctrina filosófica, y en particular gnoseológica, según la cual el conocimiento se halla fundado en la exper. Por ejemplo, se ha afirmadoLa palabra "afirmar" viene del latín affirmare y significa "dar por cierto, decir algo de una manera para que quede fuertemente parado, que no vacile". Sus componentes léxicos so que algunos aspectos del trabajo de S. FreudNació en Príbor, Austria el 6 de mayo de 1856 - Londres, 23 de septiembre de 1939, fue un médico neurólogo austriaco de origen judío, padre del psicoanálisis y una de las may o K. JungKesswil, Suiza; 26 de julio de 1875 - Küsnacht Suiza, 6 de junio de 1961, fue un médico psiquiatra, psicólogo y ensayista suizo, figura clave en la etapa inicial del psicoanáli referidos a las asociaciones de palabrasPsicológicamente hablando: Las palabras que pronunció hoy crean mi porvenir. Se dice que el pensamiento crea, que el verbo (la palabra) manifiesta. Así, cuando hablo, ya traigo o símbolos son protoconexionistas. Algunos autores, sin embargo, los critican, entendiéndolos como una especie de retorno al asociacionismoDoctrina psicológica según la cual la asociación es la base única o primaria del pensamiento y la conducta inteligentes en los humanos y en los animales. Se da una asociación.

La metáfora narrativaGénero literario fundamental o archigenérico (está presente en todas las culturas y en todas las épocas) escrito u oral, con derivaciones técnicas formales de tipo audiovisual

La metáfora narrativaGénero literario fundamental o archigenérico (está presente en todas las culturas y en todas las épocas) escrito u oral, con derivaciones técnicas formales de tipo audiovisual está relacionada con el concepto de significado y la importancia de construcción de historias. Esta busca relacionar a la mente con el contexto social, culturalRedes cerradas de conversaciones, y las conversaciones ocurren como modos de vivir juntos en el entrelazamiento del lenguajear y el emocionear. Todas las actividades humanas ocurre y de la producción social del conocimientoConjunto de datos interrelacionados adquirido a través de la experiencia, del aprendizaje (a posteriori), o a través de introspección (a priori). Acción de conocer. Facultad de. Por ejemplo,

Bruner (1990) propone la necesidadAquello que resulta indispensable para vivir en un estado de salud plena. Las necesidades se diferencian de los deseos en que el hecho de no satisfacerlas produce unos resultados n de recuperar la «mente» a través de conceptos provenientes de las ciencias humanas, luego de la «deshumanización» de lo mental producto de la revolución cognitivaEs aquello que pertenece o que está relacionado al conocimiento. Éste, a su vez, es el cúmulo de información que se dispone gracias a un proceso de aprendizaje o a la experienc, bajo una metáfora computacionalEs la ciencia que abarca las bases teóricas de la información y la computación, así como su aplicación en sistemas computacionales. El cuerpo de conocimiento de las ci. Bruner, quien abandonó el movimientoPara José Ferrater Mora el término 'movimiento' tiene con frecuencia la misma significación que los vocablos 'cambio' y 'devenir' . En principio, pues, lo que hemos dicho acerca cognitivo luego de los primeros años, afirmaba que las computadoras no crecen así como tampoco pueden crear representaciones, significadosPara Saussure es el contenido mental que le es dado al signo lingüístico. En lingüística y semiótica, el significado es el contenido mental que le es dado a un signo lingüís ni culturas.

Bruner concibe que la función principal de la mente es narrar historias y atribuirles significadosPara Saussure es el contenido mental que le es dado al signo lingüístico. En lingüística y semiótica, el significado es el contenido mental que le es dado a un signo lingüís. En este sentido, resalta tres características presentes en toda narraciónContar o relatar sucesos, historias o anécdotas, en forma ordenada y secuenciada, con un comienzo, donde se exponen los personajes, el contexto temporo-espacial y el resto de los:

a. secuencialidad, o sea, una trama continuada; b. indiferenciaLa indiferencia es una disposición que nos conecta directamente con dos estados de ánimo (negligencia y apatía) espacios en los que no se siente inclinación ni repugnancia a «fáctica», o la posesión de una estructuraEl significado del vocablo 'estructura' está relacionado con los significados de los términos 'forma', 'configuración', 'trama', 'complexo', 'conexión' (o 'interconexión'), 'e interna indiferente a la realidadEs el principio que contrapesa al principio de placer. Así como éste tiende a la satisfacción inmediata, el de realidad se apoya en la realidad externa y en la experiencia perso extralingüística; c. el carácterOrganización dinámica de los patrones conductuales del individuo; manifestación conductual de la identidad del yo, determinada por la integración del concepto de si mismo y de canónico de la narraciónContar o relatar sucesos, historias o anécdotas, en forma ordenada y secuenciada, con un comienzo, donde se exponen los personajes, el contexto temporo-espacial y el resto de los.

Este se construye cuando las creenciasCreer es el estado de la mente en el que una persona supone verdadero el conocimiento o la experiencia que tiene acerca de un suceso o cosa; cuando se objetiva, el contenido de la son transgredidas, implicando mecanismos

de legitimación y renegociación de significadosPara Saussure es el contenido mental que le es dado al signo lingüístico. En lingüística y semiótica, el significado es el contenido mental que le es dado a un signo lingüís que permiten hacer comprensible lo excepcional. A su vez, la narratividad posee un carácterOrganización dinámica de los patrones conductuales del individuo; manifestación conductual de la identidad del yo, determinada por la integración del concepto de si mismo y de dramático que consta de varios elementosSegún José Ferrater Mora, puede emplearse este término en cualquiera de los cuatro sentidos siguientes. (1) Para compendiar una serie de vocablos usados por diversos filósofos: actor, acción, meta3 definiciones básicas de la palabra Meta 1 - Prefijo usado en español y otros idiomas para indicar un concepto que es una abstracción a partir de otro concepto. La mayoría de, escenario, instrumento, problema, que es la fuerzaEn la teología cristiana, la fortaleza es una de las virtudes cardinales que consiste en vencer el temor y huir de la temeridad. Etimología y acepciones La palabra fortaleza deri de la narraciónContar o relatar sucesos, historias o anécdotas, en forma ordenada y secuenciada, con un comienzo, donde se exponen los personajes, el contexto temporo-espacial y el resto de los, que es la existenciaLa palabra "existencia" proviene de la palabra latina existere ("emerger", "aparecer", "presentarse", "salir", "hacerse visible"). Es interesante ver los matices que dicha etim de un desequilibrioEl término desequilibrio puede referirse al desajuste en ciertos parámetros que mantienen el equilibrio en un sistema. En psicopatología, un trastorno mental, o bien tra entre los cinco elementosSegún José Ferrater Mora, puede emplearse este término en cualquiera de los cuatro sentidos siguientes. (1) Para compendiar una serie de vocablos usados por diversos filósofos anteriores. El dramatismo se da en las desviaciones respecto a lo canónico, o sea, lo que es moralmente valorado. Según Bruner, la narratividad se caracteriza por mediar entre el mundoEl término 'mundo ' designa: (a) el conjunto de todas la cosas; (b) el conjunto de todas las cosas creadas; (c) el conjunto de entidades de una clase ("e l mundo de las ideas", "e canónico de la cultura y el mundoEl término 'mundo ' designa: (a) el conjunto de todas la cosas; (b) el conjunto de todas las cosas creadas; (c) el conjunto de entidades de una clase ("e l mundo de las ideas", "e más idiosincrático de las creencia, los deseosAnhelo de saciar un gusto. La agradabilidad que conmueve nuestros sentidos, sea por encauzamiento, o motivado por vivencias pasadas, o por neto reflejo corporal, ya sea por objetos y las esperanzas. Hace que lo excepcional sea comprensible y mantiene a raya a lo siniestro, salvo cuando lo siniestro se necesita como tropo. Reitera las normasProviene del latín y significa “escuadra”. Una norma es una regla que debe ser respetada y que permite ajustar ciertas conductas o actividades. En el ámbito del derecho, una de la sociedadDel latín societas. Concepto polisémico que designa a un tipo particular de agrupación de individuos que se produce tanto entre los humanos (sociedad humana –o sociedades huma sin serAtributo filosófico griego que se le adjudica a una entidad capaz de definirse a sí misma frente a un medio capaz. Se escribe con s Ser es el más general de los términos. Con l didáctica (Bruner, 1990, p. 63).

Las narraciones tienen como función la elaboración de marcos o esquemas que permiten construir un mundoEl término 'mundo ' designa: (a) el conjunto de todas la cosas; (b) el conjunto de todas las cosas creadas; (c) el conjunto de entidades de una clase ("e l mundo de las ideas", "e frenteParte frontal de la cabeza. Se trata, formalmente, de una zona de la cabeza limitada por tres zonas, dos en el cráneo y una en el cuero cabelludo. La parte superior de la frente e a la alternativa del caos así como una regulación afectivaSusceptibilidad que el ser humano experimenta ante determinadas alteraciones que se producen en su entorno. El predominio de las relaciones de pareja y de familia. La inhibición d, en tanto «… el afecto es algo así como una huella dactilar generalPara José Ferrater Mora el término 'general' se usa en lógica (y con frecuencia en epistemología y en metodología) en dos sentidos. (1) Se dice de un concepto que es general c del esquema que hay que construir… el recuerdoSe ha demostrado la existencia de un efecto de dependencia de estado referente al proceso de recuperación de información; por ejemplo, la información aprendida bajo los efectos sirve para justificar un afecto, una actitud» (Bruner, 1990, p. 68).

El funcionamiento narrativo de la mente se ha mostrado útil para comprenderActo de comprender, que quiere decir a su vez abarcar, rodear, circunscribir algo. En Matemática se dice que un conjunto se define por comprensión, cuando se mencionan las caract y explicar el funcionamiento de la memoriaLa memoria tiene la facultad de almacenar ideas, emociones y traer al consciente lo que uno quiere recordar. Puedo, después de un impacto emocional, ocultar en mi memoria miedos, autobiográfica, la conscienciaLas personas somos algo más que células, músculos, huesos y una piel que nos envuelve. Tenemos consciencia y conciencia, dos dimensiones que nos dotan de humanidad. Saber difere individualProviene de indiviso: que no se puede dividir. Se refiere a una unidad frente a otras unidades en un sistema de referencia. A veces se confunde erróneamente con clase lógica o un y otros procesos cognitivos que soportan al self (el sí mismo).

Del Manual de introducción a la psicología cognitivaLa psicología cognitiva o cognitivismo es la psicología que se encarga del estudio de la cognición; es decir, de los procesos mentales implicados en el conocimiento. Introduc. Alejandro Vásquez EcheverríaRafael Echeverría es socio fundador de Newfield Consulting, empresa que opera en Estados Unidos, España, México, Argentina, Brasil, Venezuela y Chile, dedicada a la construcció, Paul Ruiz e Ismael Apud.